Vous souhaitez exploiter un chatbot de type ChatGPT en toutes circonstances même si aucune connexion Internet n’est présente ? Ce tutorial vous explique comment installer et utiliser DeepSeek en local sur votre ordinateur – et vous pouvez aussi l’utiliser avec Mistral !

au sommaire

Au début de l'année 2025, DeepSeek a défrayé la chronique. Nous avons eu droit à un chatbot d'origine chinoise, avec des performances proches de ChatGPT ou Claude, avec comme point fort que la mise au point de cette IA générative avait nécessité énormément moins de ressources que ses équivalents américains. De fait, ChatGPTChatGPT, Claude ou aussi l'IAIA générative d'images Midjourney, nécessitent d'entraîner leurs modèles en mettant à contribution des puces informatiques fort coûteuses. DeepSeekDeepSeek affirme qu'elle obtiendrait un résultat comparable à partir d'équipements de moindre niveau.

En réalité, il s'est avéré que ChatGPT, en tant qu'IA multimodale (pouvant traiter du texte, des images, des vidéos...) était bien plus complet. Il reste que, si l'on cherche avant tout à obtenir des réponses à ses questions, DeepSeek fait souvent l'affaire.

Pourquoi installer DeepSeek en local ?

L'un des points forts de DeepSeek R1, outre le fait que ce chatbot est gratuit, est qu'il est possible, tout comme l'IA française MistralMistral, de l'utiliser en local.

Disposer de DeepSeek sur son propre ordinateur a deux atouts principaux :

- Vous pouvez accéder à DeepSeek même si vous vous trouvez à un endroit qui n'a pas de connexion Internet. De fait, tous les traitements sont effectués sur votre Mac ou votre PC.

- Vos données ne remontent pas vers les serveursserveurs de DeepSeek.

Conditions requises

Si vous comptez utiliser DeepSeek en local, sachez que toutes les données utilisées pour la réflexion de ce chatbot seront chargées sur votre ordinateur. Il faut donc prévoir entre 4 Go et 40 Go selon que vous téléchargerez une base de donnéesbase de données compressée ou non.

Il vous faut par ailleurs disposer d'un PC puissant, idéalement avec une carte graphiquecarte graphique performante comme celles de NVIDIA.

Il vous faudra aussi disposer sur votre PC ou Mac d'un « framework », soit un environnement d'exécution à même d'accueillir DeepSeek. Parmi les bibliothèques compatibles, figurent llama.cpp, Ollama, LM Studio ou Text Generation WebUI. Dans le cadre de ce tutorieltutoriel nous avons choisi Ollama.

Téléchargement de Ollama

Ollama est un outil open-source conçu pour exécuter facilement des LLM (modèles de langage) en local. Ce qui est intéressant, c'est qu'il ne nécessite pas de compétences techniques élevées. De plus, comme nous allons le voir, Ollama simplifie le téléchargement, l'installation et l'utilisation de DeepSeek - mais aussi de modèles d'IA alternatifs comme Mistral.

Rendez-vous sur le site : https://ollama.com

Cliquez sur Download, puis choisissez votre système : macOS, LinuxLinux ou Windows.

Une fois le logiciellogiciel d'installation de Ollama téléchargé, cliquez bien évidemment sur l'icôneicône correspondante afin de procéder à l'installation effective de ce framework. Cela devrait prendre cinq minutes environ.

Une fois l'installation terminée, un avis apparaît au bas de l'écran : « Ollama is running. Click here ». Cliquez sur le « here ».

Choix du modèle DeepSeek sous Ollama

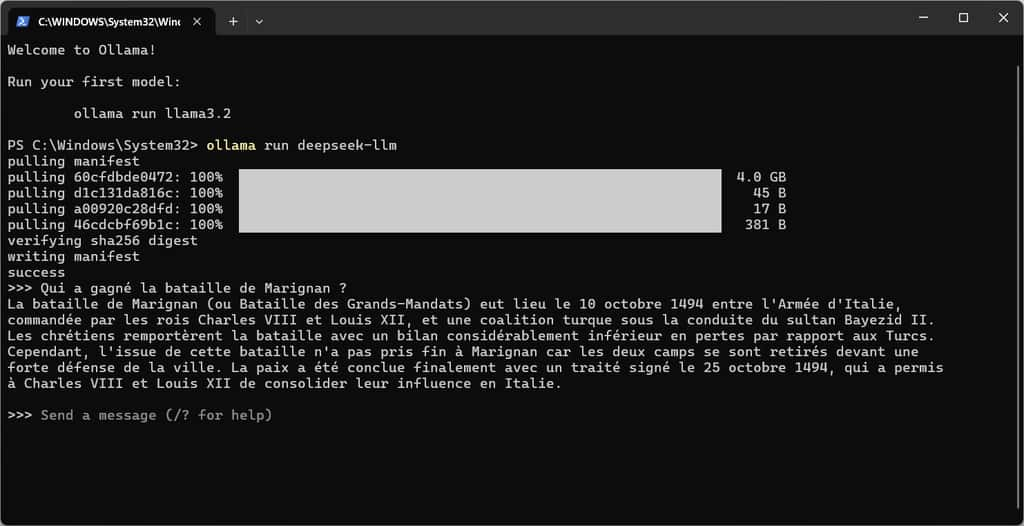

Ollama est une applicationapplication qui s'exécute depuis le mode Terminal de l'ordinateur. Celui-ci est lancé dès que vous cliquez sur le « here ».

Ollama vous invite à lancer votre premier modèle et vous propose par défaut llama3.2 de Meta. Or, ce que nous souhaitons c'est lancer deepseek. Voici la commande exacte que vous devez taper :

ollama run deepseek-llm

Vous allez alors voir plusieurs commandes sibyllines s'exécuter sous vos yeuxyeux. Elles vont procéder au téléchargement de DeepSeek sur votre Mac ou PC. Si tout se passe bien, vous voyez la mention success apparaître.

Et voilà. Vous disposez de DeepSeek sur votre ordinateur. Il n'y a plus qu'à poser des questions depuis l'interface de commande. Certes, ce n'est pas extrêmement sexy comme interface, mais au moins, vous avez un chatbot intelligent à votre disposition quel que soit le contexte.

Utiliser DeepSeek en local

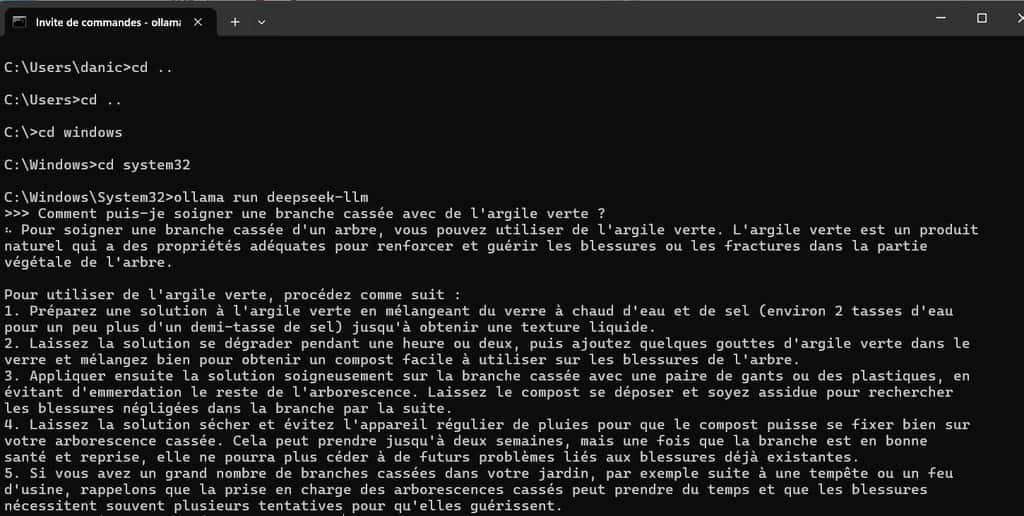

Si vous utilisez DeepSeek dans une session ultérieure, il vous faut lancer Ollama puis ouvrir l'interface de commande ainsi :

- lancer l'application Terminal sur Mac

- lancer CMD - Invite de commande sur PC. Sous cet environnement, il vous faudra probablement vous placer dans le répertoire adéquat en tapant d'abord cette commande : CDCD .. jusqu'à remonter au dossier source du PC. Puis CD WINDOWS et enfin CD SYSTEM32.

Tapez alors ollama run deepseek-llm et le tour est joué ! Vous avez accès à DeepSeek en local. Sachez-le : si votre matériel est peu performant, DeepSeek sera lent à répondre vos questions.

Si jamais à un moment donné, vous souhaitez désinstaller DeepSeek en local, tapez :

ollama rm deepseek-llm puis désinstallez Ollama depuis le système.

Utiliser Mistral en local

Vous pouvez aussi, une fois Ollama installé, charger un modèle tel que celui du français Mistral. Les commandes à utiliser sont les suivantes :

Pour télécharger Mistral :

ollama pull mistral

Pour l'utiliser :

ollama run mistral

Et voilà ! Vous disposez d'un chatbot exploitable à volonté, et sans qu'il soit nécessaire d'avoir une connexion InternetInternet.